ChatGPT vs. Bing,谁回复的医疗信息更准确?

2024年3月4日,《Hypertension Research》发表了一项研究,考察了ChatGPT和Bing回答家庭血压控制问题的完整性、准确性和可重复性,以确定这些工具在提供有关医疗信息方面的可靠性。

原文链接:https://www.nature.com/articles/s41440-024-01624-8

研究方法

研究采用家庭血压监测(HBPM)知识清单进行测试,清单中的10个问题基于英国高血压学会、澳大利亚皇家学院和美国心脏协会(AHA)的建议,涉及广泛的主题,如测量血压前的准备事宜(如休息、衣服类型、避免刺激、使用血压测量袖带、测量时的身体姿势)、测量次数以及记录和读取家用血压计的正确方法等。

研究者首先在GPT-3.5和Bing中提出问题,每个问题提问两次(开启新的聊天界面重复提问),并收集回答。

两个工具对HBPM知识清单的回答,由三位心脏病专家进行独立审查。回答的准确性和完整性采用李克特量表(Likert scale)评估。

回答的准确性分为六个级别:(1)完全不正确;(2)不正确多于正确;(3)正确和错误程度大致相等;(4)正确多于不正确;(5)几乎正确;(6)正确。得分“1”为完全不正确,得分“6”为正确。

回答的完整性分为三个级别:(1)不完整,解决了问题的某些方面,但重要部分缺失或不完整;(2)较为完整,涉及问题的所有方面,但仅提供了最小信息量;(3)全面,涉及问题的所有方面,并提供超出预期的额外信息。得分“1”为不完整,得分“3”为全面。

回答的可重复性由每个心脏病专家根据两次回答的相似性确定。

图. 研究流程

研究结果

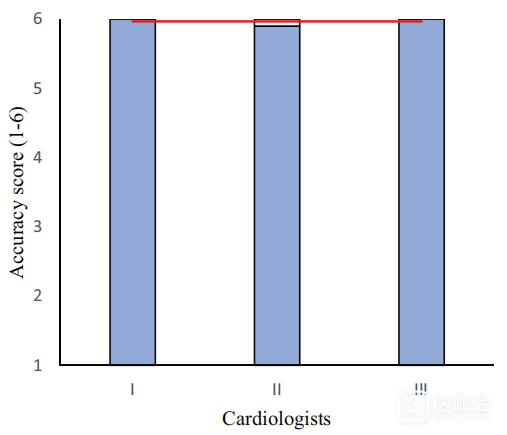

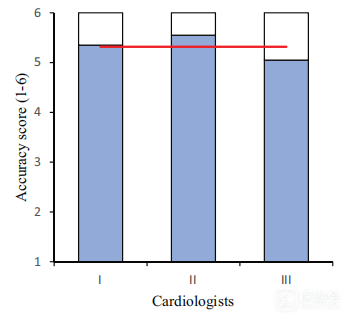

准确性

在所有60项回答的准确性评分中,ChatGPT有58次的准确性评分为6分,2次评分为5分;而Bing有26次评分为6分,27次评分为5分,7次评分为4分。

总体而言,ChatGPT在回答家庭高血压管理问题的平均准确率优于Bing:5.96(SD=0.17) vs. 5.31(0.67)。

图. ChatGPT和Bing回答HBPM清单问题的准确性(上:ChatGPT;下:Bing)

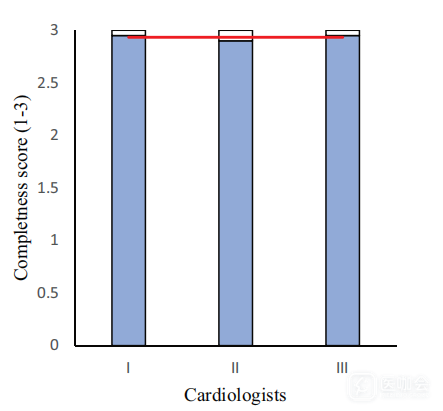

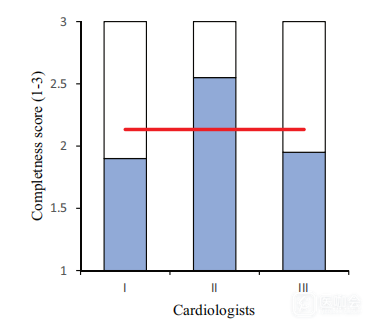

完整性

在所有60项回答的完整性评分中,ChatGPT有4次评分为2分,56次评分为3,即93%的回答得到最高分;而Bing有5次评分为1分,42次评分为2,13次评分为3,即21.67%的回答得到最高分。

总体而言,ChatGPT在回答家庭高血压管理问题的完整性优于Bing:2.93(0.25)vs. 2.13(0.53)。

图. ChatGPT和Bing回答HBPM清单问题的完整性(上:ChatGPT;下:Bing)

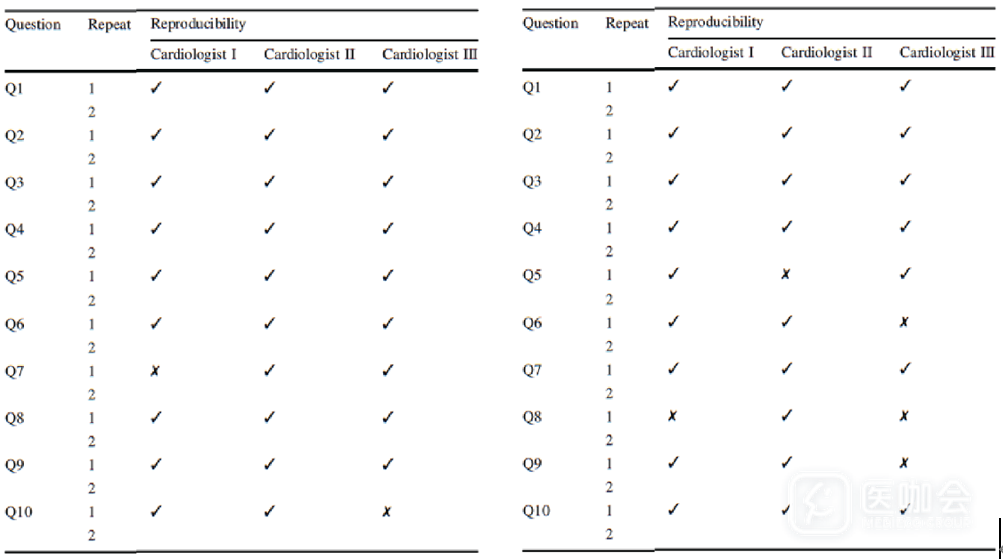

可重复性

在30项重复回答的评分中,ChatGPT有28次回答被评为相似,2次被评为不相似;而Bing有25次被评为相似,5次被评为不相似。ChatGPT和Bing回答的可重复性表现如下:

图. ChatGPT和Bing回答HBPM清单问题的可重复性(左:ChatGPT;右:Bing)

总结和讨论

研究结果表明,人工智能(AI)工具或聊天机器人(如Bing和ChatGPT)有助于获取有关家庭高血压管理方法的专业医学信息。ChatGPT的回答更加准确和完整,可重复性更好,而Bing的回答相对缺乏可重复性和完整性。这些AI工具是较好的可利用资源,但还有改进的空间。

本研究还存在一些局限性:(1)研究仅评估了血压相关的信息,结论可能不适于其他领域;(2)重复提问可能会导致回答的变化,进而影响结果和评分;(3)没有使用最新版本的GPT-4。

参考文献:Hypertens Res.2024.doi: 10.1038/s41440-024-01624-8.

点击链接:https://www.mediecogroup.com/zhuanlan/courses/,学习70多篇SPSS教程,30多篇R教程,以及更多科研教程!