AI生成50篇医学论文摘要,10多篇被审稿人认为是真实论文

2022年12月底,预印本平台bioRxiv发布了一项研究,发现有些人工智能写出的论文摘要足以乱真,以至于人工审核都无法发现。这项研究来自Catherine Gao领导的研究小组。

https://www.biorxiv.org/content/10.1101/2022.12.23.521610v1

人工智能聊天机器人ChatGPT可以根据用户提示生成逼真的文本,这个"大型语言模型"是一个基于神经网络的系统,可以通过学习大量人类生成的文本来学习执行任务。软件公司OpenAI于11月30日发布了该工具,并且提供用户免费使用。

在这项研究中,Catherine Gao领导的小组用ChatGPT生成医学论文摘要,以测试人工审核是否能识别出来。研究人员要求ChatGPT根据《JAMA》、《NEJM》、《BMJ》、《Lancet》和《Nature Medicine》的论文节选内容,生成50份医学研究摘要。

然后,研究者通过抄袭检测器和人工智能检测器对这些生成的摘要与原始论文的摘要进行比较,此外,还有一组医学研究人员来人工审核这些摘要。

研究结果显示,人工智能ChatGPT生成的医学摘要,顺利通过了抄袭检测:原创性得分的中位数为100%,表明没有发现抄袭行为。人工智能检测器识别出66%的生成摘要。人工审稿的表现也不如预期,只正确识别出了68%的生成摘要和86%的真实摘要。也就是说,人工审稿将32%的AI生成摘要识别为真实摘要,将14%的真实摘要识别为AI生成的。

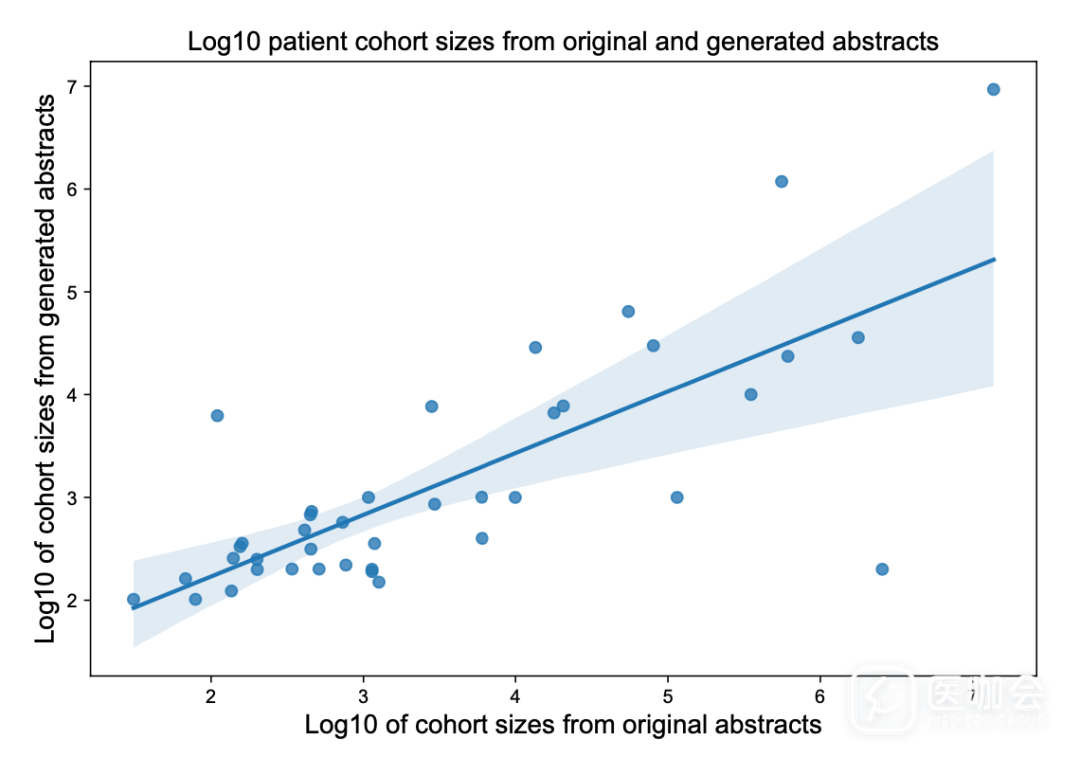

图. 人工智能生成摘要与原始文章的相似度非常高

(图源:https://www.biorxiv.org/content/10.1101/2022.12.23.521610v1)

该研究表示:"ChatGPT写出了令人可信的科学摘要,然而,使用模型来帮助科学写作,可接受的界限仍有待确定"。

计算机科学家Arvind Narayanan表示:"任何严谨的科学家都不太可能使用ChatGPT来生成摘要。生成的摘要是否能被检测出来无关紧要,问题是这个工具是否能生成一个准确和令人信服的摘要”。

研究人工智能社会影响的Irene Solaiman说:"这些模型是根据过去的信息训练出来的,而社会和科学的进步往往来自于与过去不同的思考方式,或更加开放的思考方式,使用人工智能一定会限制发展"。

作者建议,应该制定政策来杜绝使用人工智能生成的文本。如果机构允许在某些情况下使用该技术,就应该围绕所担忧的问题制定明确的规则。将于2023年7月在夏威夷檀香山举行的大型人工智能会议已经宣布,禁止使用ChatGPT和其他人工智能语言工具撰写论文。

参考文章:

https://www.nature.com/articles/d41586-023-00056-7

更多阅读: